Faux pas s’en faire. Depuis l’émergence de l’intelligence artificielle générative, une flopée d’images surréalistes – et fausses – déferle sur les réseaux sociaux. Loin de lutter contre ces spams de nouvelle génération, les géants de la tech les encouragent, quitte à financer les projets les plus malveillants.

Acculé par ses problèmes d’argent, Cooper Redfield accepte un petit boulot qui consiste à tester un jeu vidéo en phase d’essai, conçu par l’entreprise Saito Gemu. Une fois le casque de réalité virtuelle sur la tête, il voit apparaître une araignée géante puis, progressivement, le jeu vidéo apprend à générer automatiquement toutes les phobies de Cooper Redfield.

Ce décryptage a été réalisé par Data for Good, une association qui veut mettre les données au service de l’intérêt général, pour Chaleurs actuelles : la rubrique de Vert consacrée à la désinformation climatique et à l’extrême droite. Abonnez-vous gratuitement à la newsletter Chaleurs actuelles pour tout savoir de ces sujets majeurs.

Cette histoire – fictive –, c’est celle de l’épisode Playtest de la saison 3 de la série télé Black Mirror. Mais, comme souvent avec cette œuvre dystopique, la réalité rattrape la fiction.

En témoigne une vidéo virale – publiée sur les réseaux sociaux dans la vraie vie, cette fois –, qui commence de façon très réaliste : on y voit une altercation devant une porte de métro et un être humain qui sort de la rame… avant de se transformer en un monstre terrifiant.

À elle seule, cette vidéo comptabilise 130 millions de vues, bien plus qu’un journal télévisé de 20h sur TF1. En réalité, celle-ci a été générée via l’intelligence artificielle (IA). Et, sur l’ensemble de ses publications en ligne, son créateur, shiverchain, compte plus d’un milliard de faux contenus semblables.

Des «mixtures» à la sauce IA

Ce sont des «AI slops» (slop signifie littéralement «pâtée» ou «mixture», en anglais), des contenus médiocres produits en masse par des outils d’intelligence artificielle générative. Ils trouvent souvent la meilleure manière de capter notre attention : par le sordide, l’absurde, le mignon ou le spectaculaire. Cela s’applique aussi bien à des textes, des images ou une combinaison de ces éléments, comme des sites internet ou des vidéos. Le slop, c’est un peu le spam d’internet : on ne l’a pas demandé, mais il vient pourrir et saturer notre quotidien digital – encouragé par le modèle d’économie de l’attention des plateformes numériques.

Son but premier est de donner l’illusion d’un contenu humain et d’occuper l’espace en ligne, afin de capter des revenus publicitaires ou d’attirer l’attention des moteurs de recherche. En somme, l’AI slop est un bruit de fond numérique généré par des intelligences artificielles.

Si ce phénomène existe depuis un moment, c’est avec l’arrivée des outils grand public d’IA générative en 2022, comme ChatGPT (pour générer du texte) ou Midjourney (pour générer des images), qu’il a explosé.

Instagram, Facebook et Tiktok sont les temples des AI slops. Sur Facebook, par exemple, on croise régulièrement des images de personnages de tout âge qui fabriquent des sculptures avec tout type d’objet, et qui sont – littéralement – incroyables. Mais aussi des émirs qui élèvent des dragons, des serpents géants en Amazonie, des ours qui échappent aux requins, des tsunamis géants ou des maisons de rêve.

Mark Zuckerberg a lui-même liké l’image d’une fausse sculpture de cheval en brioche qui, ironiquement, avait initialement été postée pour sensibiliser sur ces contenus synthétiques.

Le reste d’internet n’y échappe pas – sur Amazon, on trouve déjà en vente des livres quasi intégralement générés par IA ; dans la recherche scientifique, des publications de qualité médiocre explosent sur le portail Google Scholar ; dans l’actualité sportive, ce sont des articles de presse qui sont générés en masse ; sur Spotify, de fausses chansons de Noël remplissent les playlists ; sur Youtube, des vidéos synthétiques de philosophes stoïciens et masculinistes pullulent par centaines, tout comme les faux podcasts de faits divers.

Le paroxysme de cette tendance ? Les «Italian brainrot», sorte de Pokémon ratés qui portent des noms en simili-italien.

Ces créatures sont mises en scène dans des batailles, ont des potins amoureux, et sont mentionnées dans des micro-trottoirs viraux, où l’on doit choisir sa créature préférée. L’ensemble de ces vidéos cumulent ainsi des milliards de vues sur les réseaux sociaux.

À la frontière entre la culture populaire et geek, mais sans appartenance à une licence payante comme les Pokémon, il n’a pas fallu attendre pour que cette tendance soit récupérée par la communication des entreprises, comme en témoigne une campagne de publicité Ryanair qui met en scène le crocodile bombardier Bombardillo crocodillo. De la même manière, Ikea a fait la promotion de chaises en brioche sur Facebook. Notons toutefois que les commentaires en ligne sous ces contenus non-sollicités sont très souvent négatifs.

Le développeur Simon Willison a été l’un des premiers à populariser le terme «slop». Dans une interview pour le Guardian, il rappelle qu’avant la naissance du terme «spam», beaucoup ne considéraient pas que bombarder les boîtes mail de publicités non voulues relevait d’un comportement abusif ; de la même manière, dit-il, «générer et publier du contenu issu d’IA sans relecture ni filtre est une mauvaise pratique» qu’il faut stigmatiser.

Usine à déchets numériques

L’essor fulgurant des IA génératives a transformé la production de contenu en ligne en une usine à déchets numériques. Les logiciels grand public comme ChatGPT, ou les générateurs d’images comme Midjourney, peuvent créer en quelques secondes des textes cohérents ou des visuels réalistes sur n’importe quel sujet, et pour un coût économique dérisoire.

Et les modèles d’IA sont de plus en plus performants et réalistes, ce qui leur permet de correspondre fidèlement aux instructions des internautes – même les plus farfelues. Cette évolution technique est particulièrement visible lorsque l’on compare deux fausses vidéos de Will Smith mangeant des spaghetti, créées par l’IA en 2023 et en 2025 (après la sortie du modèle Veo3 de Google).

Cette capacité de production synthétique, couplée aux algorithmes de recommandation, a transformé internet en un laboratoire d’expérimentation sauvage. Les créateurs de slop testent massivement différents contenus, analysent les performances, puis reproduisent ce qui fonctionne. Les youtubeurs Maxence Duboeuf ou Ibrahim Kamara expliquent comment le faire dans des vidéos tuto.

La démarche est très simple : détecter une tendance, générer du contenu, itérer selon les résultats, puis basculer vers la prochaine bonne opportunité. Comme le raconte 404 Media, le créateur de contenus viraux FutureRiderUS (280 000 followers sur Instagram) illustre parfaitement cette logique opportuniste et l’absence totale de cohérence éditoriale : après avoir produit de faux contenus sur les incendies de Los Angeles début 2025, le compte a immédiatement basculé vers la guerre à Gaza, puis vers d’autres sujets qui suscitent de nombreuses recherches sur internet.

Les géants des réseaux favorisent les AI slops

Les plateformes comme Instagram ou Facebook ne subissent pas passivement cette pollution – elles l’encouragent activement. Une étude menée par les universités de Stanford et Georgetown démontre que l’algorithme de Facebook booste délibérément les contenus générés par IA, les injectant massivement dans les flux de recommandation.

Par exemple, le système de recommandation «suggéré pour vous» fonctionne comme un amplificateur de slops. Une fois qu’un·e utilisateur·ice a interagi avec une image IA, l’algorithme lui recommande systématiquement d’autres contenus générés artificiellement, indépendamment du sujet. Cette mécanique crée des bulles de pollution informationnelle, où l’internaute se retrouve submergé de contenus synthétiques.

Il vous suffit de faire le test, regardez sur Instagram les quelques vidéos recommandées dans cet article et, en dix minutes, votre fil d’actualité en sera rempli.

Cette complicité algorithmique s’enracine dans l’économie de l’attention qui gouverne l’écosystème numérique : plus le contenu est étrange ou émotionnellement chargé, plus il génère d’engagement. Et chaque seconde d’attention ainsi captée se monnaye directement en revenus publicitaires.

Pourquoi les AI slop prolifèrent

1. La monétisation

Pour les «créateurs» de ces contenus synthétiques, l’intérêt est clair : monétiser les vues. Instagram rémunère environ 100-120 dollars par million de vues. Un créateur comme shiverchain, dont les vidéos de monstres cumulent des centaines de millions de vues, a probablement été rémunéré des dizaines ou des centaines de milliers d’euros.

Une stratégie connexe : rediriger cet engagement massif vers des sites saturés de publicités, ou vendre des produits. Le créateur FutureRiderUS vend cyniquement un cours à 19,99 dollars permettant de «gagner 5 000 dollars par mois avec des vidéos virales – pas d’expérience demandée – commencez aujourd’hui et regardez votre vie changer.»

Pour les plateformes numériques, c’est une situation gagnant-gagnant qui augmente leurs revenus publicitaires – les revenus publicitaires de Google ont été multipliés par 2,5 depuis 2017.

2. Arnaques et exploitation malveillante

L’AI slop sert aussi de filet de pêche numérique pour «attraper» les populations vulnérables. Les contenus émotionnellement chargés – images d’enfants en détresse, animaux abandonnés, récits inspirants bidons – fonctionnent comme des tests de crédulité à grande échelle, en particulier sur Facebook, à tel point que ces contenus sont aussi surnommés les boomer traps (les pièges à boomers – ces personnes nées pendant le baby boom).

Les escrocs utilisent ces contenus pour repérer des cibles potentielles : les utilisateur·rices qui interagissent massivement avec du contenu douteux révèlent leur vulnérabilité aux manipulations. L’IA permet ensuite de générer des arnaques plus sophistiquées : faux témoignages, profils fictifs ou sites de e-commerce entiers.

3. Influence politique et saturation attentionnelle

L’AI Slop est l’une des manifestations parfaites de la célèbre stratégie de Steve Bannon – architecte de la première victoire de Donald Trump avec son fameux mantra : «Flood the zone with shit» (inondez la zone avec de la merde). En noyant l’espace public sous un déluge de contenus génériques, il permet aux véritables enjeux structurels de disparaître de l’agenda collectif.

Il est aujourd’hui difficile de rattacher les créateurs de slops à des appartenances politiques et des intentions cachées. Mais nous savons, par exemple, que le réseau russe Pravda a publié des millions d’articles depuis l’invasion de l’Ukraine, saturant l’espace informationnel de propagande automatisée.

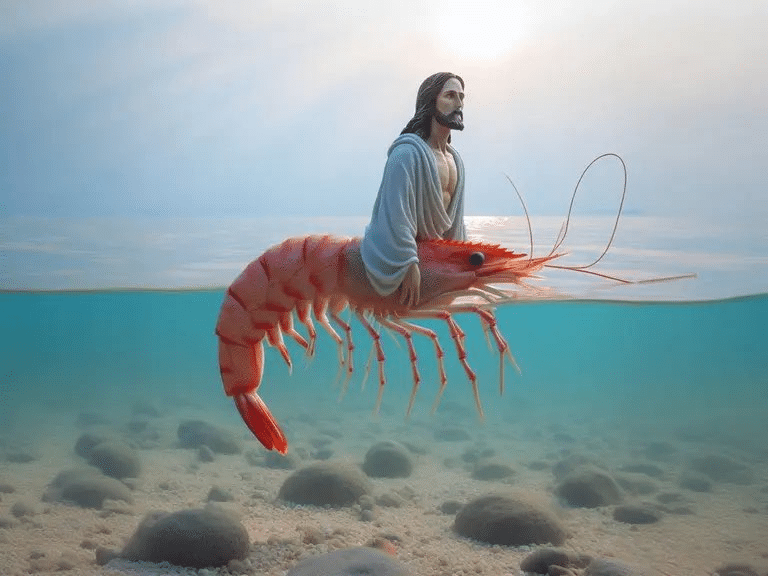

Nous assistons donc à une saturation attentionnelle, où l’information de qualité et l’actualité brûlante se noient dans un océan de médiocrité algorithmique. Comme le souligne Jean-Lou Fourquet, co-auteur de la Dictature des algorithmes (Tallandier, 2024) : «Le monde brûle (au sens propre ET figuré) et on regarde Jésus se transformer en crevette.»