Tout faux, tout flamme. Les célèbres lettres «Hollywood» dévorées par le feu : ces images iconiques ont fait le tour des réseaux sociaux, depuis le 10 janvier 2025. Sauf qu’elles sont fausses et générées par l’intelligence artificielle.

Depuis le début des incendies à Los Angeles (États-Unis), le 7 janvier dernier, des images de destruction générées par intelligence artificielle (IA) ont été massivement partagées sur Facebook, Instagram, X ou TikTok. Parmi elles, celles du signe Hollywood en feu ont suscité beaucoup de réactions.

Si la qualité de ces images est plus ou moins grossière (lettres mal alignées, structures incohérentes, détails fantaisistes), il n’en faut pas plus pour semer le doute dans notre flux informationnel continu et jeter de l’huile numérique sur le feu.

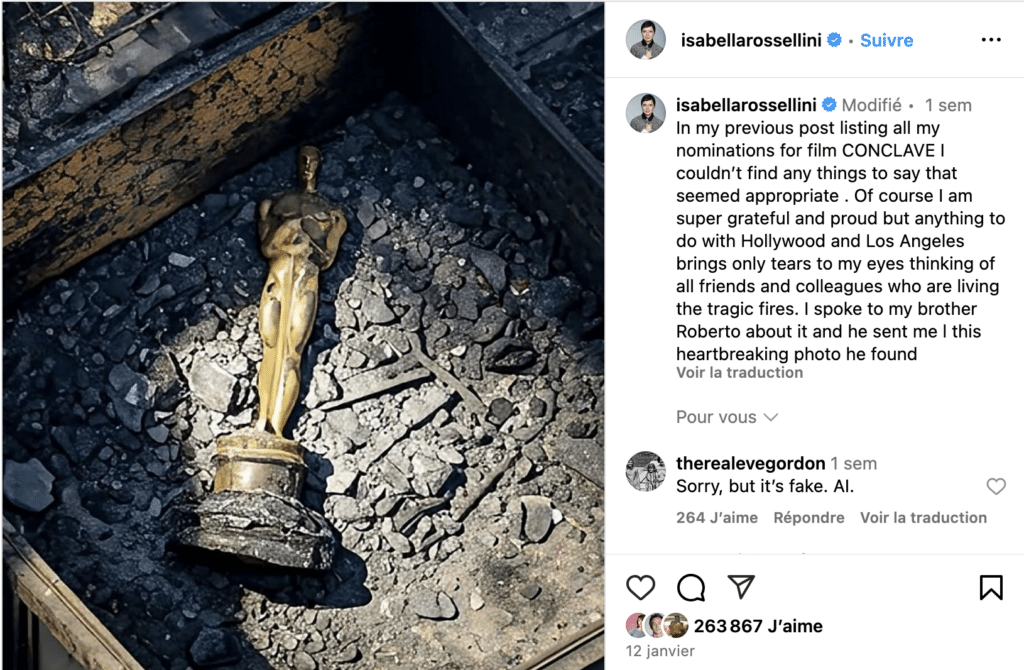

D’autant plus quand les stars s’en mêlent : le 14 janvier, l’actrice Isabella Rossellini poste (sans le savoir ?) une fausse image d’un trophée des Oscars au milieu des débris d’une maison détruite par le feu. Cette photo a été «likée» par 200 000 personnes et vue des millions de fois.

Alors, quand des images bien réelles – et spectaculaires – d’un McDonald’s en proie aux flammes se diffusent, nous basculons dans un régime de vérité paradoxal, où tout devient à la fois authentique et suspect.

Les motivations derrière chacun de ces faux restent floues : simple quête d’engagement viral et de monétisation sur les réseaux sociaux ? Déstabilisation idéologique ou ingérence ? Critique détournée des politiques publiques de gestion des incendies et de résilience climatique de la ville de Los Angeles ? L’impact, lui, est tangible : les autorités et fact-checkers doivent consacrer des ressources précieuses à démentir ces fausses informations.

Faisons le test : regardez, au hasard, les photos des feux publiées sur Instagram et demandez-vous si vous êtes capable de déceler les fausses images et, surtout, si vous faites 100% confiance à celles que vous pensez être authentiques.

Et lorsque la puissance des deepfakes (des trucages photo, audio ou vidéo) se combine à l’amplification algorithmique des réseaux sociaux, c’est l’effet cocktail garanti ! De nombreuses théories du complot ont été relayées, fausses images à l’appui, qui expliquaient l’origine criminelle des feux par une tentative d’empêcher l’investiture de Trump, ou encore justifiaient l’impréparation des pompiers par des dons excessifs de matériel à l’Ukraine, il y a plus de deux ans. Ces messages cumulent des milliers de vues.

L’enjeu n’est donc plus de distinguer le vrai du faux, mais de comprendre comment nous pourrons maintenir une perception partagée du réel, dans un monde où la fiction peut être générée plus vite que nous ne pouvons la vérifier, et où les fausses informations sont diffusées en moyenne six fois plus vite que les vraies.

Ce décryptage a été réalisé par nos ami·es de Data for good, une association qui veut mettre les données au service de l’intérêt général, pour Chaleurs actuelles : la rubrique de Vert consacrée à la désinformation climatique et à l’extrême droite. Abonnez-vous gratuitement à la newsletter Chaleurs actuelles pour tout savoir de ces sujets majeurs.

À lire aussi

-

Vera, Decode democracy : deux nouvelles intelligences artificielles pour débusquer les fausses informations

Hiii haaa ! Alors que la désinformation liée au climat gagne du terrain, deux intelligences artificielles viennent de voir le jour pour vérifier les faits et donner des arguments à celles et ceux qui luttent contre les fake news. Nous les avons testées pour vous. -

Électricité, eau, minéraux, CO2 : on a tenté de mesurer l’empreinte écologique de ChatGPT

GPT la planète ? L’impact environnemental de l’incontournable outil d’intelligence artificielle est souvent insoupçonné et sous-estimé, et risque bien d’empirer dans les années à venir. Décryptage.